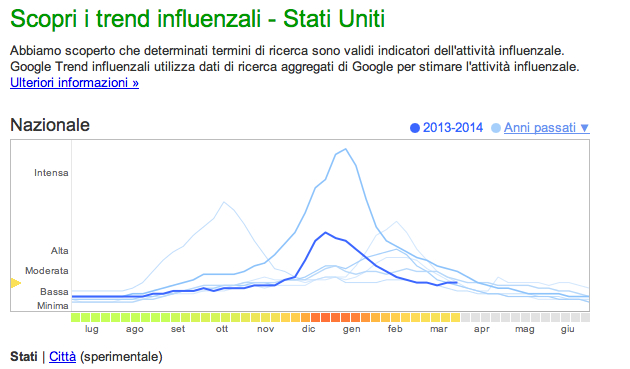

Nelle ultime settimane si è diffuso su testate online e social network un dibattito ampio sull’efficacia del modello di previsione dell’influenza offerto da Google Flu trends (GFT), a partire già dal 2008. L’assunto di Google è chiaro e lineare: la ricerca su google di parole chiave che rimandano a sintomi influenzali, permette di costruire un alert sull’affacciarsi della patologia e costruire la geografia in real time della diffusione. Una dashboard online che richiama la certezza grafica degli analytics consente a tutti di accedere ai dati, disaggregati per paese, e, “sperimentale” per città.

ll GFT nasce in stretta associazione con il sistema di monitoraggio dell’influenza del Centers for Disease Control and Prevention (CDC) americano che basa l’osservatorio sui report inviati dai centri medici. L’obiettivo è ottenere dati in linea con quelli del CDC con qualche settimana di anticipo.

Cosa succede? Un’analisi pubblicata su Nature del febbraio 2013, seguita da una ricerca approfondita di un team di studiosi della Northeastern University e di Harvard, pubblicata nel marzo 2014 su Science rimettono in discussione il modello.

In particolare mostrano che il GFT ha sovrastimato la diffusione dell’influenza e nella stagione 2012-2013 è arrivato a registrare più del doppio dei risultati del CDC. L’errore si rileva in 100 settimane su 108. I ricercatori denunciano la hubris dei big data e i media si scatenano nella cerimonia di degradazione di GOOGLE.

Alcune testate con toni più neutri come Il New York Times e il Guardian, altre con forzature strumentali dei risultati della ricerca come Business Week. Con uno slittamento semantico dalla previsione alla cura per niente ovvio la Stampa titola: “L’influenza non si cura con google”. Fa eccezione l’Atlantic che si schiera in “Defense of google flu trends”, mostrando che gli apocalittici di oggi erano gli integrati di ieri.

Il dibattito è interessante perché segnala come sia sempre più importante oggi sfuggire al paradigma della centralità dei “dati”, che siano “BIG” o “piccoli ma buoni”. Come scrive il Financial Times quello che manca è la teoria, la capacità di raccogliere e analizzare i dati per rispondere a domande complesse. Il problema dei “big data” non è il big, ma l’idea che la quantità possa eludere il problema dei modelli interpretativi e causali.

I ricercatori accusano Google di rilevare dati che Google stesso ha contribuito a creare, con i cambiamenti dell’algoritmo generati da esigenze commerciali. In pratica, sostengono, suggerendo i termini di ricerca, Google avrebbe indotto un incremento dell’uso di determinati termini, su cui si basa la previsione dell’influenza. Contemporaneamente, misurano l’errore di Google a partire da un metodo che a sua volta non viene messo in discussione. La necessità di aggiornare l’algoritmo è solo di Google e non di CDP. E se lo scarto fosse anche dovuto al fatto che la rete dei centri medici che fornisce i dati non è più sufficiente da sola a fornire i dati sull’influenza perché segmenti sempre più significativi della popolazione praticano l’autodiagnosi e l’autoterapia? Non si tratta semplicemente di integrare i dati di GFT e CDP, come fanno i ricercatori, ma di rendere più complesso e articolato il modello interpretativo.

A sua volta Google dichiara candidamente: “We have found a close relationship between how many people search for flu-related topics and how many people actually have flu symptoms“. E il malato immaginario? E le ondate di allarme sociale sulle malattie, alimentate dai media e dalle autorità pubbliche? Perché non essere più modesti e offrirsi come barometro dell’allarme sociale sull’influenza? Non ci interessa anche il contagio sociale oltre quello epidemiologico? L’allarme sociale affolla inutilmente il pronto soccorso o dissipa risorse in medicine inutili. La spesa pubblica soffre anche di questo.

Discarica del sociale, in cui riversiamo le nostre paure, i nostri bisogni, i nostri dubbi, forse Google allora può essere usato anche in altri modi che non in una competizione tra “big data” e “good data”. La complessità generata dalla molteplicazione dei soggetti che producono, immaginano, diffondono, vivono la salute e la malattia richiede piattaforme integrate, sguardi ibridi e la capacità di riscoprire l’importanza di modelli teorici, senza i quali i dati, tutti, grandi o piccoli, rischiano di essere ciechi. Dobbiamo recuperare al cuore dei big data lo sguardo sintetico a priori di Kant.